เกือบทุกอุตสาหกรรมใช้การขูดเว็บเพื่อดึงและวิเคราะห์ข้อมูลจากอินเทอร์เน็ต บริษัทต่างๆ ใช้ข้อมูลที่รวบรวมมาเพื่อสร้างกลยุทธ์ทางธุรกิจและผลิตภัณฑ์ใหม่ๆ ข้อมูลของคุณมีค่า บริษัทต่างๆ กำลังใช้ข้อมูลของคุณเพื่อสร้างรายได้ เว้นแต่คุณกำลังดำเนินการเพื่อปกป้องความเป็นส่วนตัวของคุณ

ถ้าธุรกิจใหญ่ๆ กำลังทำอยู่ ทำไมคุณไม่ทำเหมือนกันล่ะ? การเรียนรู้วิธีขูดเว็บไซต์สามารถช่วยให้คุณพบข้อตกลงที่ดีที่สุด รวบรวมลูกค้าเป้าหมายสำหรับธุรกิจของคุณ หรือแม้แต่ช่วยให้คุณหางานใหม่ได้

ใช้บริการ Web Scraping

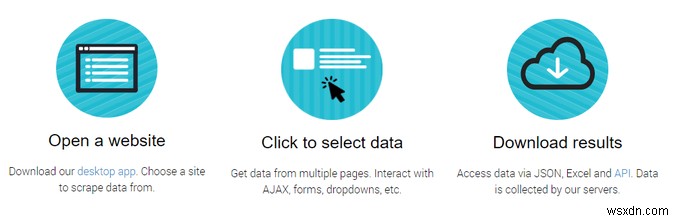

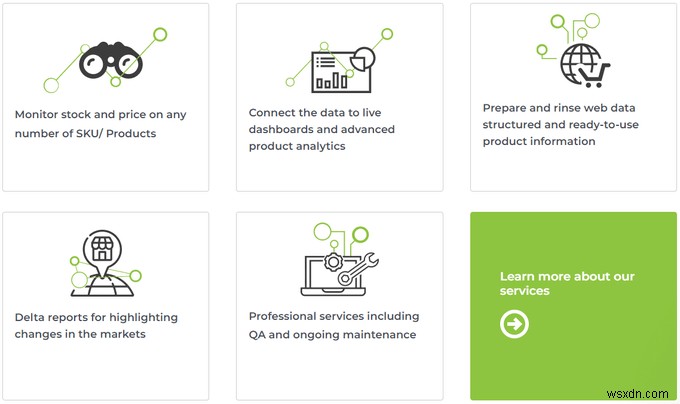

วิธีที่รวดเร็วและง่ายที่สุดในการรวบรวมข้อมูลจากอินเทอร์เน็ตคือการใช้บริการขูดเว็บแบบมืออาชีพ หากคุณต้องการรวบรวมข้อมูลจำนวนมาก บริการอย่าง Scrapinghub อาจเหมาะสม พวกเขาให้บริการขนาดใหญ่และใช้งานง่ายสำหรับการรวบรวมข้อมูลออนไลน์

หากคุณกำลังมองหาบางสิ่งในขนาดที่เล็กกว่า ParseHub นั้นคุ้มค่าที่จะลองขูดเว็บไซต์สองสามแห่ง ผู้ใช้ทั้งหมดเริ่มต้นด้วยแผนฟรี 200 หน้า โดยไม่ต้องใช้บัตรเครดิต ซึ่งสามารถสร้างขึ้นในภายหลังได้ผ่านระบบการกำหนดราคาแบบแบ่งชั้น

แอปขูดเว็บ

สำหรับวิธีการขูดเว็บไซต์ที่รวดเร็ว ฟรี และสะดวก Web Scraper Chrome Extension เป็นตัวเลือกที่ยอดเยี่ยม

มีช่วงการเรียนรู้เล็กน้อย แต่นักพัฒนาได้จัดเตรียมเอกสารและวิดีโอแนะนำที่ยอดเยี่ยม Web Scraper เป็นหนึ่งในเครื่องมือที่ง่ายที่สุดและดีที่สุดสำหรับการรวบรวมข้อมูลขนาดเล็ก โดยมีให้เลือกมากกว่าในฟรี ชั้นกว่ามากที่สุด

ใช้ Microsoft Excel เพื่อขูดเว็บไซต์

สำหรับบางสิ่งที่คุ้นเคยกว่านี้เล็กน้อย Microsoft Excel มีคุณลักษณะการขูดเว็บขั้นพื้นฐาน หากต้องการทดลองใช้ ให้เปิดเวิร์กบุ๊ก Excel ใหม่ แล้วเลือก ข้อมูล แท็บ คลิก จากเว็บ ในแถบเครื่องมือ และทำตามคำแนะนำในตัวช่วยสร้างเพื่อเริ่มคอลเลกชัน

จากที่นั่น คุณมีหลายทางเลือกในการบันทึกข้อมูลลงในสเปรดชีตของคุณ ดูคำแนะนำในการขูดเว็บด้วย Excel สำหรับบทแนะนำแบบเต็ม

ใช้ไลบรารี่ Scrapy Python

หากคุณคุ้นเคยกับภาษาการเขียนโปรแกรม Python แล้ว Scrapy เป็นห้องสมุดที่สมบูรณ์แบบสำหรับคุณ ช่วยให้คุณสามารถตั้งค่า "แมงมุม" ที่กำหนดเองซึ่งรวบรวมข้อมูลเว็บไซต์เพื่อดึงข้อมูล จากนั้นคุณสามารถใช้ข้อมูลที่รวบรวมในโปรแกรมของคุณ หรือส่งออกไปยังไฟล์ได้

กวดวิชา Scrapy ครอบคลุมทุกอย่างตั้งแต่การขูดเว็บขั้นพื้นฐานไปจนถึงการรวบรวมข้อมูลตามกำหนดเวลาของแมงมุมหลายตัวในระดับมืออาชีพ การเรียนรู้วิธีใช้ Scrapy เพื่อขูดเว็บไซต์ไม่ได้เป็นเพียงทักษะที่มีประโยชน์สำหรับความต้องการของคุณเท่านั้น นักพัฒนาซอฟต์แวร์ที่รู้วิธีใช้ Scrapy เป็นที่ต้องการสูง ซึ่งอาจนำไปสู่อาชีพใหม่ได้

Python Scrapy Tutorial - แมวและแมงมุม? การขูดเว็บ Reddit ด้วย Scrapy [2020]

ดูวิดีโอนี้บน YouTube

ใช้ไลบรารี่ซุปงูที่สวยงาม

Beautiful Soup เป็นไลบรารี่ Python สำหรับการขูดเว็บ คล้ายกับ Scrapy แต่มีมานานแล้ว ผู้ใช้หลายคนพบว่า Beautiful Soup ใช้ง่ายกว่า Scrapy

มันไม่ได้มีคุณสมบัติครบถ้วนเหมือน Scrapy แต่สำหรับกรณีการใช้งานส่วนใหญ่ มันเป็นความสมดุลที่สมบูรณ์แบบระหว่างฟังก์ชันการทำงานและความง่ายในการใช้งานสำหรับโปรแกรมเมอร์ Python

กวดวิชาซุปที่สวยงาม - การขูดเว็บใน Python

ดูวิดีโอนี้บน YouTube

ใช้ Web Scraping API

หากคุณสะดวกที่จะเขียนโค้ดการขูดเว็บด้วยตัวเอง คุณยังต้องรันโค้ดในเครื่อง ซึ่งเป็นเรื่องปกติสำหรับการดำเนินงานขนาดเล็ก แต่เมื่อการรวบรวมข้อมูลของคุณขยายใหญ่ขึ้น ก็จะใช้แบนด์วิดท์อันมีค่า ซึ่งอาจทำให้เครือข่ายของคุณช้าลง

การใช้ Web Scraping API สามารถถ่ายงานบางส่วนไปยังเซิร์ฟเวอร์ระยะไกล ซึ่งคุณสามารถเข้าถึงได้ผ่านโค้ด วิธีนี้มีหลายตัวเลือก รวมถึงตัวเลือกที่มีคุณลักษณะครบถ้วนและราคาอย่างมืออาชีพ เช่น Dexi และเพียงแค่ดึงบริการกลับมา เช่น ScraperAPI

ทั้งสองมีค่าใช้จ่ายในการใช้งาน แต่ ScraperAPI เสนอการเรียก API ฟรี 1,000 ครั้งก่อนการชำระเงินใดๆ เพื่อทดลองใช้บริการก่อนที่จะทำข้อตกลง

ใช้ IFTTT เพื่อขูดเว็บไซต์

IFTTT เป็นเครื่องมืออัตโนมัติที่ทรงพลัง คุณสามารถใช้มันเพื่อทำให้ทุกอย่างเป็นอัตโนมัติได้ รวมถึงการรวบรวมข้อมูลและการขูดเว็บ

ประโยชน์มหาศาลประการหนึ่งของ IFTTT คือการผสานรวมกับบริการเว็บมากมาย ตัวอย่างพื้นฐานที่ใช้ Twitter อาจมีลักษณะดังนี้:

- ลงชื่อเข้าใช้ IFTTT และเลือก สร้าง

- เลือก ทวิตเตอร์ ในเมนูบริการ

- เลือก ค้นหาใหม่จากทวีต

- ป้อนคำค้นหาหรือแฮชแท็ก แล้วคลิก สร้างทริกเกอร์

- เลือก Google ชีต เป็นบริการการดำเนินการของคุณ

- เลือก เพิ่มแถวในสเปรดชีต และทำตามขั้นตอน

- คลิก สร้างการกระทำ

ดูวิดีโอนี้บน YouTube

ในไม่กี่ขั้นตอนสั้นๆ คุณได้สร้างบริการอัตโนมัติที่จะบันทึกทวีตที่เชื่อมโยงกับคำค้นหาหรือแฮชแท็กและชื่อผู้ใช้พร้อมกับเวลาที่โพสต์

ด้วยตัวเลือกมากมายในการเชื่อมต่อบริการออนไลน์ IFTTT หรือทางเลือกอื่นจึงเป็นเครื่องมือที่สมบูรณ์แบบสำหรับการรวบรวมข้อมูลอย่างง่ายโดยการขูดเว็บไซต์

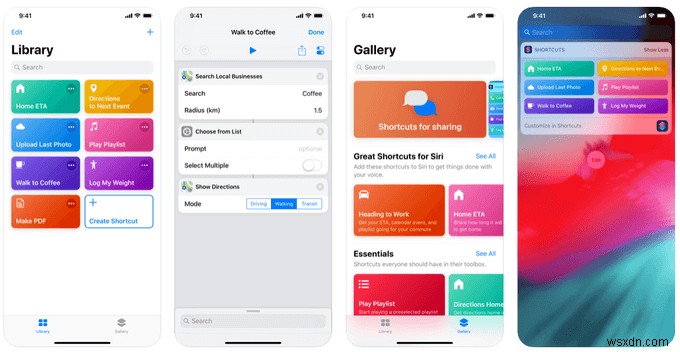

การขูดเว็บด้วยแอปคำสั่งลัด Siri

สำหรับผู้ใช้ iOS แอปคำสั่งลัดเป็นเครื่องมือที่ยอดเยี่ยมสำหรับการเชื่อมโยงและทำให้ชีวิตดิจิทัลของคุณเป็นไปโดยอัตโนมัติ แม้ว่าคุณอาจคุ้นเคยกับการผสานรวมระหว่างปฏิทิน รายชื่อติดต่อ และแผนที่ แต่ก็สามารถทำอะไรได้มากกว่านั้นอีกมาก

ในโพสต์โดยละเอียด ผู้ใช้ Reddit u/keveridge ได้สรุปวิธีใช้นิพจน์ทั่วไปกับแอปคำสั่งลัดเพื่อรับข้อมูลโดยละเอียดจากเว็บไซต์

นิพจน์ทั่วไปช่วยให้สามารถค้นหาแบบละเอียดมากขึ้น และสามารถทำงานในหลายๆ ไฟล์เพื่อส่งคืนเฉพาะข้อมูลที่คุณต้องการ

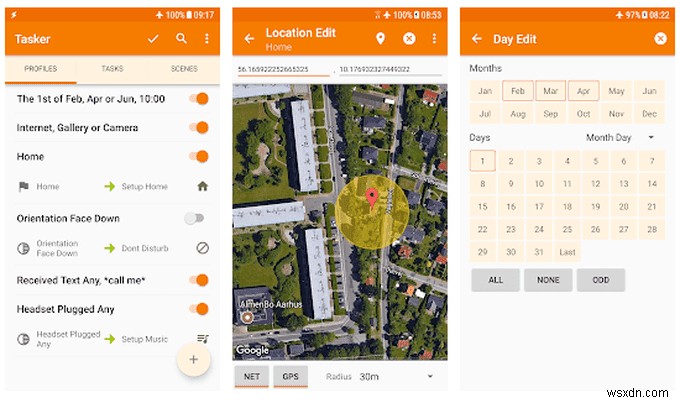

ใช้ Tasker สำหรับ Android เพื่อค้นหาเว็บ

หากคุณเป็นผู้ใช้ Android ไม่มีตัวเลือกง่ายๆ ในการขูดเว็บไซต์ คุณสามารถใช้แอป IFTTT โดยมีขั้นตอนที่อธิบายไว้ข้างต้น แต่ทาซเคอร์อาจเหมาะสมกว่า

มีให้ในราคา $ 3.50 ใน Play Store หลายคนมองว่า Tasker เป็นพี่น้องที่อายุมากกว่าของ IFTTT มีตัวเลือกมากมายสำหรับการทำงานอัตโนมัติ ซึ่งรวมถึงการค้นหาเว็บแบบกำหนดเอง การแจ้งเตือนเมื่อข้อมูลในเว็บไซต์ที่เลือกเปลี่ยนแปลง และความสามารถในการดาวน์โหลดเนื้อหาจาก Twitter

แม้ว่าจะไม่ใช่วิธีการขูดเว็บแบบเดิม แต่แอประบบอัตโนมัติสามารถให้ฟังก์ชันการทำงานส่วนใหญ่เหมือนกับเครื่องมือขูดเว็บแบบมืออาชีพโดยไม่จำเป็นต้องเรียนรู้วิธีเขียนโค้ดหรือชำระค่าบริการรวบรวมข้อมูลออนไลน์

การขูดเว็บอัตโนมัติ

ไม่ว่าคุณจะต้องการรวบรวมข้อมูลสำหรับธุรกิจของคุณหรือทำให้ชีวิตของคุณสะดวกขึ้น การขูดเว็บเป็นทักษะที่ควรค่าแก่การเรียนรู้

ข้อมูลที่คุณรวบรวม เมื่อจัดเรียงอย่างเหมาะสมแล้ว จะทำให้คุณมีความเข้าใจมากขึ้นในสิ่งที่คุณสนใจ เพื่อนของคุณ และลูกค้าธุรกิจของคุณ