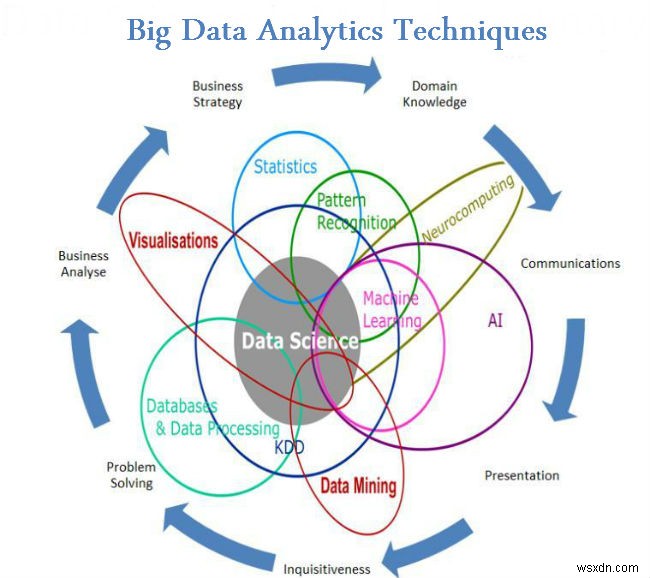

จนถึงตอนนี้ในบล็อกของฉันเกี่ยวกับ Big Data ฉันได้แนะนำคุณเกี่ยวกับแง่มุมต่างๆ ของ Big Data ตั้งแต่ความหมายที่แท้จริงไปจนถึงข้อเท็จจริง สิ่งที่ควรทำและไม่ควรทำ ในบล็อกที่แล้ว เราได้เห็นเทคนิคการวิเคราะห์ข้อมูลขนาดใหญ่ นำรายการเพิ่มเติมในบล็อกนี้

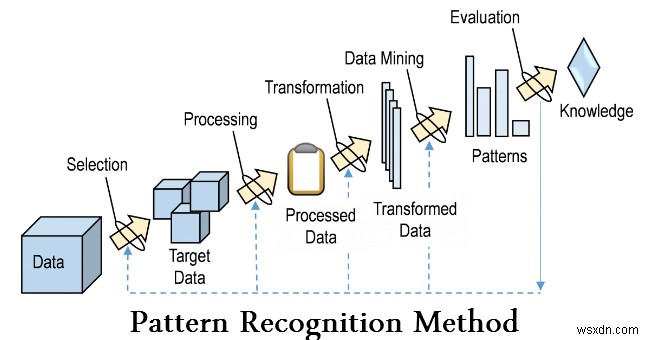

- การจดจำรูปแบบ

การจดจำรูปแบบเป็นสาขาหนึ่งของแมชชีนเลิร์นนิงที่เน้นการจดจำรูปแบบและความสม่ำเสมอในข้อมูล แม้ว่าในบางกรณีจะถือว่าเกือบจะเหมือนกันกับแมชชีนเลิร์นนิง ในหลายกรณีระบบจดจำรูปแบบได้รับการฝึกฝนจากข้อมูล "การฝึกอบรม" ที่มีป้ายกำกับ (การเรียนรู้แบบมีผู้ดูแล) แต่เมื่อไม่มีข้อมูลที่มีป้ายกำกับให้ใช้งาน อัลกอริทึมอื่นสามารถใช้เพื่อค้นหารูปแบบที่ไม่รู้จักก่อนหน้านี้ได้ (การเรียนรู้แบบไม่มีผู้ดูแล)

- การสร้างแบบจำลองเชิงทำนาย

การวิเคราะห์เชิงคาดการณ์ประกอบด้วยเทคนิคต่างๆ มากมายที่คาดการณ์ผลลัพธ์ในอนาคตตามข้อมูลในอดีตและข้อมูลปัจจุบัน ในทางปฏิบัติ การวิเคราะห์เชิงคาดการณ์สามารถนำไปใช้กับเกือบทุกสาขาวิชา ตั้งแต่การทำนายความล้มเหลวของเครื่องยนต์ไอพ่นตามกระแสข้อมูลจากเซ็นเซอร์หลายพันตัว ไปจนถึงการทำนายการเคลื่อนไหวครั้งต่อไปของลูกค้าตามสิ่งที่พวกเขาซื้อ เมื่อพวกเขาซื้อ หรือแม้แต่อะไร พวกเขาพูดบนโซเชียลมีเดีย เทคนิคการวิเคราะห์เชิงคาดการณ์ขึ้นอยู่กับวิธีการทางสถิติเป็นหลัก

- การวิเคราะห์การถดถอย

นี่เป็นเทคนิคที่ใช้ตัวแปรอิสระและผลกระทบของตัวแปรตาม นี่อาจเป็นเทคนิคที่มีประโยชน์มากในการพิจารณาการวิเคราะห์โซเชียลมีเดีย เช่น ความน่าจะเป็นในการพบรักผ่านแพลตฟอร์มอินเทอร์เน็ต

- การวิเคราะห์ความรู้สึก

การวิเคราะห์ความคิดเห็นช่วยให้นักวิจัยระบุความรู้สึกของผู้พูดหรือนักเขียนเกี่ยวกับหัวข้อหนึ่งๆ กำลังใช้การวิเคราะห์ความรู้สึกเพื่อช่วย:

- ปรับปรุงบริการในเครือโรงแรมโดยวิเคราะห์ความคิดเห็นของแขก

- กำหนดสิ่งจูงใจและบริการเพื่อตอบสนองสิ่งที่ลูกค้าต้องการอย่างแท้จริง

- กำหนดว่าผู้บริโภคคิดอย่างไรจริง ๆ ตามความคิดเห็นจากโซเชียลมีเดีย

- การประมวลผลสัญญาณ

การประมวลผลสัญญาณเป็นเทคโนโลยีที่ช่วยให้ครอบคลุมทฤษฎีพื้นฐาน แอปพลิเคชัน อัลกอริทึม และการดำเนินการประมวลผลหรือถ่ายโอนข้อมูลที่มีอยู่ในรูปแบบทางกายภาพ สัญลักษณ์ หรือนามธรรมที่แตกต่างกันจำนวนมากซึ่งกำหนดไว้อย่างกว้างๆ ว่า สัญญาณ . มันใช้การแทนทางคณิตศาสตร์ สถิติ การคำนวณ ฮิวริสติกและภาษาศาสตร์ พิธีการ และเทคนิคสำหรับการเป็นตัวแทน การสร้างแบบจำลอง การวิเคราะห์ การสังเคราะห์ การค้นพบ การกู้คืน การตรวจจับ การได้มา การสกัด การเรียนรู้ ความปลอดภัย หรือนิติวิทยาศาสตร์ แอปพลิเคชันตัวอย่างรวมถึงการสร้างแบบจำลองสำหรับการวิเคราะห์อนุกรมเวลาหรือการใช้การรวมข้อมูลเพื่อกำหนดการอ่านที่แม่นยำยิ่งขึ้นโดยการรวมข้อมูลจากชุดของแหล่งข้อมูลที่มีความแม่นยำน้อยกว่า (เช่น การแยกสัญญาณออกจากสัญญาณรบกวน)

- การวิเคราะห์เชิงพื้นที่

การวิเคราะห์เชิงพื้นที่เป็นกระบวนการที่เราเปลี่ยนข้อมูลดิบให้เป็นข้อมูลที่เป็นประโยชน์ It is the process of examining the locations, attributes, and relationships of features in spatial data through overlay and other analytical techniques in order to address a question or gain useful knowledge. Spatial analysis extracts or creates new information from spatial data.

- Statistics

In statistics, exploratory data analysis is an approach to analyzing data sets to summarize their main characteristics, often with visual methods. A statistical model can be used or not, but primarily EDA is for seeing what the data can tell us beyond the formal modelling or hypothesis testing task. Statistical techniques are also used to reduce the likelihood of Type I errors (“false positives”) and Type II errors (“false negatives”). An example of an application is A/B testing to determine what types of marketing material will most increase revenue.

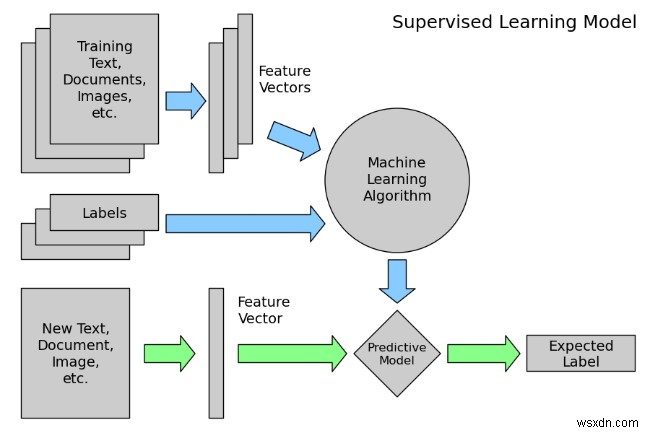

- Supervised learning

Supervised learning is the machine learning task of inferring a function from labeled training data. The training data consist of a set of training examples . In supervised learning, each example is a pair consisting of an input object (typically a vector) and a desired output value (also called the supervisory signal ). A supervised learning algorithm analyzes the training data and produces an inferred function, which can be used for mapping new examples.

- Social Network Analysis

Social network analysis is a technique that was first used in the telecommunications industry, and then quickly adopted by sociologists to study interpersonal relationships. It is now being applied to analyze the relationships between people in many fields and commercial activities. Nodes represent individuals within a network, while ties represent the relationships between the individuals.

- Simulation

Modeling the behavior of complex systems, often used for forecasting, predicting and scenario planning. Monte Carlo simulations, for example, are a class of algorithms that rely on repeated random sampling, i.e., running thousands of simulations, each based on different assumptions. The result is a histogram that gives a probability distribution of outcomes. One application is assessing the likelihood of meeting financial targets given uncertainties about the success of various initiatives

- Time Series Analysis

Time series analysis comprises methods for analyzing time series data in order to extract meaningful statistics and other characteristics of the data. Time series data often arise when monitoring industrial processes or tracking corporate business metrics. Time series analysis accounts for the fact that data points taken over time may have an internal structure (such as autocorrelation, trend or seasonal variation) that should be accounted for. Examples of time series analysis include the hourly value of a stock market index or the number of patients diagnosed with a given condition every day.

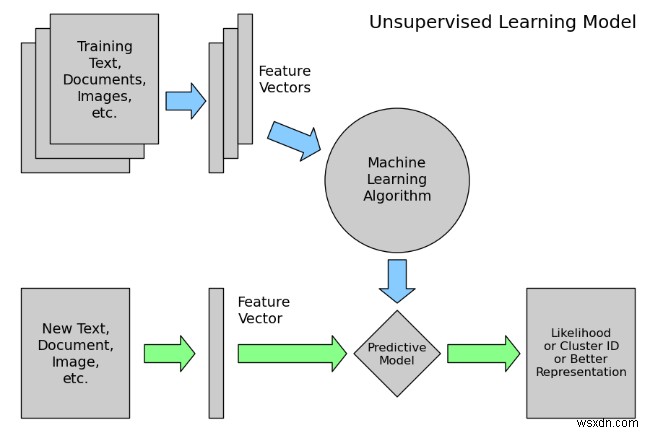

- Unsupervised Learning

Unsupervised learning is the machine learning task of inferring a function to describe hidden structure from unlabeled data. Since the examples given to the learner are unlabeled, there is no error or reward signal to evaluate a potential solution – this distinguishes unsupervised learning from supervised learning and reinforcement learning.

However, unsupervised learning also encompasses many other techniques that seek to summarize and explain key features of the data.

- Visualization

Data visualization is the preparation of data in a pictorial or graphical format. It enables decision makers to see analytics presented visually, so they can grasp difficult concepts or identify new patterns. With interactive visualization, you can take the concept a step further by using technology to drill down into charts and graphs for more detail, interactively changing what data you see and how it’s processed.

Conclusion

Big data analytics has been one of the most important breakthroughs in the information technology industry. In fact, Big Data has shown its importance and need almost in all sectors, and in all the departments of those industries. There is not a single aspect of life which has not been affected by Big Data, not even our personal lives. Hence we need Big Data Analytics to manage this huge amounts of Data efficiently.

As said before this list is not exhaustive. Researchers are still experimenting on new ways of Analyzing this huge amounts of Data which is present in a variety of forms whose speed of generation is increasing with time to derive values for our specific uses.