ด้วยภาพต้นฉบับที่เพียงพอ จึงไม่ยากที่จะทำให้ Jordan Peele เป็นประธานาธิบดี Obama, Jimmy Fallon เป็น John Oliver หรือ Jon Snow เป็นโฆษกของแฟน Game of Thrones ที่ผิดหวัง ในตอนแรก การจับ Deepfakes นั้นไม่ยากเกินไป แม้แต่สิ่งที่ดีที่สุดก็ยังมีการแจกของที่มองเห็นได้ เช่น การเบลอ การบิดเบือน และความแตกต่างของใบหน้าที่แปลกประหลาดซึ่งทำให้พวกเขาดู “ไม่ปกติ”

มันเป็นเกม cat-and-mouse และดูเหมือนว่าทันทีที่เราเรียนรู้วิธีหนึ่งในการตรวจหา deepfakes รุ่นต่อไปจะแก้ไขข้อบกพร่อง ในการต่อสู้กับปัญหานั้น มีวิธีแก้ปัญหาที่เชื่อถือได้ไหมในการหาว่าวิดีโอใดพยายามหลอกเรา

ภาพเบาะแส

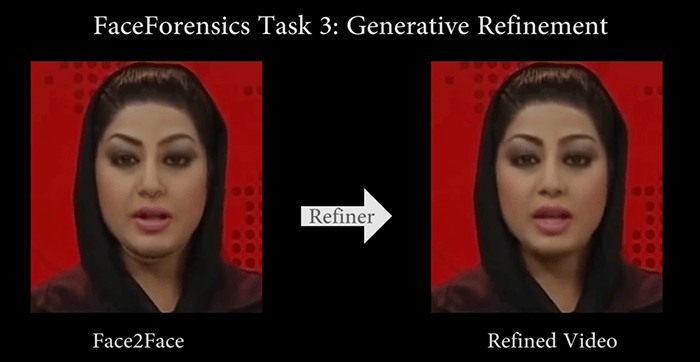

สิ่งประดิษฐ์ไม่ได้เป็นเพียงสิ่งของที่ Indiana Jones ใส่ไว้ในพิพิธภัณฑ์เท่านั้น แต่ยังมีความคลาดเคลื่อนเล็กน้อยหลังจากมีการจัดการภาพหรือวิดีโอ ในช่วงแรก Deepfakes สิ่งเหล่านี้มักจะถูกจับได้ด้วยตามนุษย์ และ Deepfakes ที่ไม่ดีอาจยังคงมีสัญญาณเตือนบางอย่าง เช่น การเบลอที่ขอบ ใบหน้าที่เรียบเกินไป คิ้วสองชั้น ข้อบกพร่อง หรือความรู้สึก "ผิดธรรมชาติ" โดยทั่วไปว่าเข้ากับใบหน้า .

อย่างไรก็ตาม ส่วนใหญ่แล้ว เทคนิคต่างๆ ได้รับการปรับปรุงจนถึงจุดที่สิ่งประดิษฐ์เหล่านี้มองเห็นได้เฉพาะกับอัลกอริธึมอื่นที่รวบรวมข้อมูลวิดีโอและตรวจสอบสิ่งต่างๆ ในระดับพิกเซลเท่านั้น บางอย่างก็สร้างสรรค์ได้ เช่น เทคนิคหนึ่งที่ตรวจสอบว่าทิศทางของจมูกตรงกับทิศทางของใบหน้าหรือไม่ ความแตกต่างนั้นบอบบางเกินกว่าที่มนุษย์จะรับมือได้ แต่เครื่องจักรกลับกลายเป็นว่าทำได้ดีทีเดียว

ข้อมูลไบโอเมตริกซ์

ชั่วขณะหนึ่ง ดูเหมือนว่ากุญแจสำคัญในการเปิดโปง Deepfakes คือการขาดรูปแบบการกะพริบตามธรรมชาติเนื่องจากการขาดแคลนภาพต้นฉบับที่ "ปิดตา" ไม่นานนักเทคโนโลยี Deepfake รุ่นต่อไปจะรวมการกะพริบตาได้ดีขึ้น แต่ลดประสิทธิภาพของเทคนิคนั้นลงอย่างรวดเร็ว

ตัวบ่งชี้ไบโอเมตริกซ์อื่น ๆ ยังไม่ได้รับการถอดรหัสอย่างสมบูรณ์ แต่เช่นเดียวกับนิสัยใจคอส่วนบุคคลที่อัลกอริทึมไม่สามารถทำให้เป็น Deepfake โดยอัตโนมัติได้อย่างง่ายดายเพราะพวกเขาต้องการความเข้าใจบริบทของภาษาที่ใช้ นิสัยเล็กๆ น้อยๆ เช่น การกะพริบถี่ๆ เมื่อคุณรู้สึกประหลาดใจ หรือเลิกคิ้วเมื่อคุณถามคำถาม บุคคลจอมปลอมอาจหยิบขึ้นมาใช้และนำไปใช้ได้ แต่ไม่จำเป็นว่าจะต้องถูกเวลาเท่านั้น เนื่องจากพวกเขาไม่สามารถ (ยัง) ทราบได้โดยอัตโนมัติว่าเมื่อใดควร ปรับใช้การเคลื่อนไหวเหล่านั้น

AI ที่สามารถอ่านการเต้นของหัวใจโดยใช้ภาพวิดีโอมีแอปพลิเคชันมากมายนอกเหนือจากการตรวจจับ Deepfake แต่การมองหาการเคลื่อนไหวเป็นระยะและการเปลี่ยนสีที่อัตราการเต้นของหัวใจของสัญญาณสามารถช่วยระบุตัวปลอมที่สร้างขึ้นโดย AI ของแจกที่ชัดเจนที่สุดคือเมื่อ Deepfake ไม่มีการเต้นของหัวใจเลย แต่ Deepfakes มักมีจังหวะ ถึงกระนั้น ความผิดปกติ (เช่น ส่วนต่างๆ ของใบหน้าที่แสดงอัตราการเต้นของหัวใจต่างกัน) ยังคงช่วยระบุ Deepfake ได้

โครงการ AI

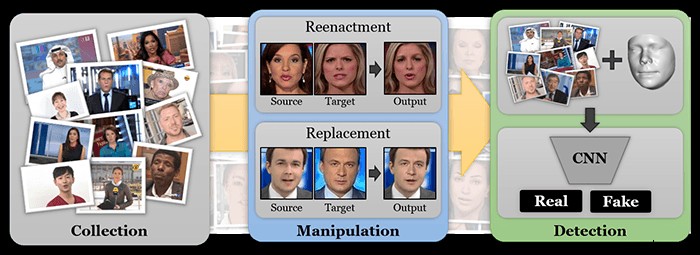

ชื่อใหญ่จำนวนมากสนใจที่จะแก้ปัญหา Deepfake เป็นอย่างมาก Facebook, Google, MIT, Oxford, Berkeley และบริษัทสตาร์ทอัพและนักวิจัยอื่นๆ มากมายกำลังแก้ปัญหานี้ด้วยการฝึกปัญญาประดิษฐ์เพื่อตรวจจับวิดีโอปลอมโดยใช้วิธีการที่ระบุไว้ข้างต้น เป็นต้น

สิ่งหนึ่งที่ทั้ง Facebook และ Google กำลังทำงานกันอยู่คือการสร้างชุดข้อมูลของวิดีโอคุณภาพสูงของนักแสดงที่ทำสิ่งต่างๆ ซึ่งพวกเขาใช้เพื่อสร้าง Deepfakes AI ที่ได้รับการฝึกอบรมเกี่ยวกับสิ่งเหล่านี้สามารถค้นหาสัญญาณปากโป้งของ Deepfakes ได้ และได้รับมอบหมายให้ตรวจหาสิ่งเหล่านั้น

แน่นอนว่าวิธีนี้ใช้ได้ตราบใดที่นักวิจัยยังคงสร้าง Deepfakes โดยใช้เทคโนโลยีล่าสุด ซึ่งหมายความว่าจะมีความล่าช้าเล็กน้อยระหว่างการค้นพบเทคนิค Deepfake ใหม่ล่าสุดและอัลกอริทึมเหล่านี้ที่สามารถจับได้ อย่างไรก็ตาม หากโชคดี การทดลองโดยใช้หนูจริงเพื่อระบุ Deepfakes จะขยายออกไปและทำให้เราได้เปรียบ

การรับรองความถูกต้อง

เทคโนโลยีการตรวจจับไม่ใช่คำตอบที่สมบูรณ์สำหรับ Deepfakes เนื่องจากอาจไม่เคยมีอัตราความสำเร็จ 100% Deepfakes ที่ใช้เวลาและเงินไปบ้างอาจผ่านการทดสอบการดมกลิ่นและวิธีการ AI ในปัจจุบันจำนวนมาก และอย่าลืมว่าอินเทอร์เน็ตทำงานอย่างไร แม้ว่าของปลอมเหล่านี้จะถูกจับได้ แต่คนบางกลุ่มก็มีแนวโน้มที่จะหมุนเวียนและเชื่อต่อไป

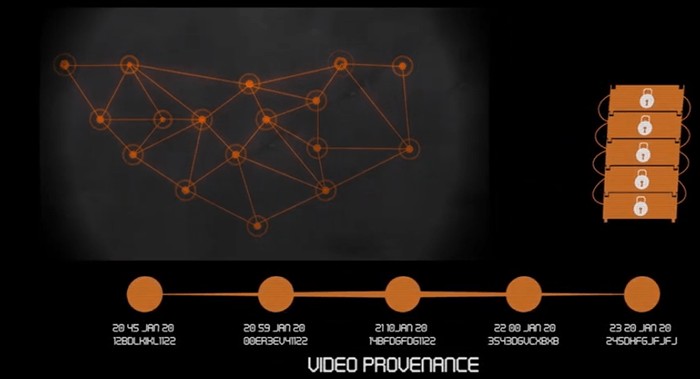

ด้วยเหตุนี้จึงเป็นสิ่งสำคัญที่ต้องมีกลไกการตรวจสอบรูปแบบหนึ่ง – การพิสูจน์ว่าวิดีโอใดเป็นต้นฉบับหรือบางอย่างที่สามารถระบุได้ว่าวิดีโอได้รับการแก้ไขหรือไม่ นั่นคือสิ่งที่บริษัทอย่าง Factom, Ambervideo และ Axiom กำลังทำโดยการเข้ารหัสข้อมูลเกี่ยวกับวิดีโอบนบล็อกเชนที่ไม่เปลี่ยนรูป

แนวคิดพื้นฐานเบื้องหลังโครงการเหล่านี้จำนวนมากคือ ข้อมูลในไฟล์วิดีโอหรือที่สร้างโดยกล้องบางตัวสามารถใช้เพื่อสร้างลายเซ็นเฉพาะที่จะเปลี่ยนแปลงได้หากวิดีโอถูกดัดแปลง ในที่สุด วิดีโอที่อัปโหลดไปยังโซเชียลมีเดียอาจมาพร้อมกับตัวเลือกในการสร้างรหัสการตรวจสอบสิทธิ์ที่ผู้อัปโหลดดั้งเดิมสามารถลงทะเบียนบนบล็อคเชนเพื่อพิสูจน์ว่าพวกเขาเป็นเจ้าของวิดีโอดั้งเดิม

โซลูชันเหล่านี้มีปัญหาชุดของตนเอง เช่น การเข้ารหัสวิดีโอเปลี่ยนข้อมูลในไฟล์และเปลี่ยนลายเซ็นโดยที่เนื้อหาวิดีโอไม่เปลี่ยนแปลงจริง หรือการตัดต่อวิดีโอที่ถูกต้องตามกฎหมายทำให้ลายเซ็นเสียหาย อย่างไรก็ตาม ในสถานการณ์ที่มีเดิมพันสูง เช่น ธุรกรรมเชิงพาณิชย์ที่ใช้รูปภาพเพื่อยืนยันการจัดส่งหรือรับการสนับสนุนจากนักลงทุน การมีชั้นการตรวจสอบสิทธิ์แบบนี้สามารถช่วยป้องกันการฉ้อโกงที่เกี่ยวข้องกับ Deepfake ได้

Deepfakes อันตรายกว่า Photoshop หรือไม่

ณ จุดนี้ เราทุกคนแค่คิดว่าภาพอาจไม่ใช่ของจริงเพราะเราทราบดีว่ามีเทคโนโลยีที่มีอยู่เพื่อทำให้เกือบทุกอย่างดูเหมือนจริงในภาพนิ่ง ในที่สุด เราอาจเริ่มเข้าถึงวิดีโอด้วยความสงสัยแบบเดียวกัน เนื่องจากการปลอมแปลงเป็นเรื่องง่ายและน่าเชื่อเหมือนที่ Photoshop กำลังทำการแก้ไขภาพในปัจจุบัน แม้ว่าจะมีการรับรู้ทั่วไป แต่ก็เป็นเรื่องง่ายที่จะจินตนาการถึงเหตุการณ์ในชีวิตจริงมากมายที่เริ่มต้นด้วย Deepfake ที่มีคุณภาพและตรงเวลาในอนาคตอันใกล้